Screenless i hardware jako klient AI. O Humane AI Pin.

Interakcja z komputerem może być jeszcze naturalniejsza niż dotąd. Humane AI próbuje dokonać takiego przełomu.

There are only two ways to make money in business: one is to bundle; the other is unbundle - Jim Barksdale, CEO Netscape

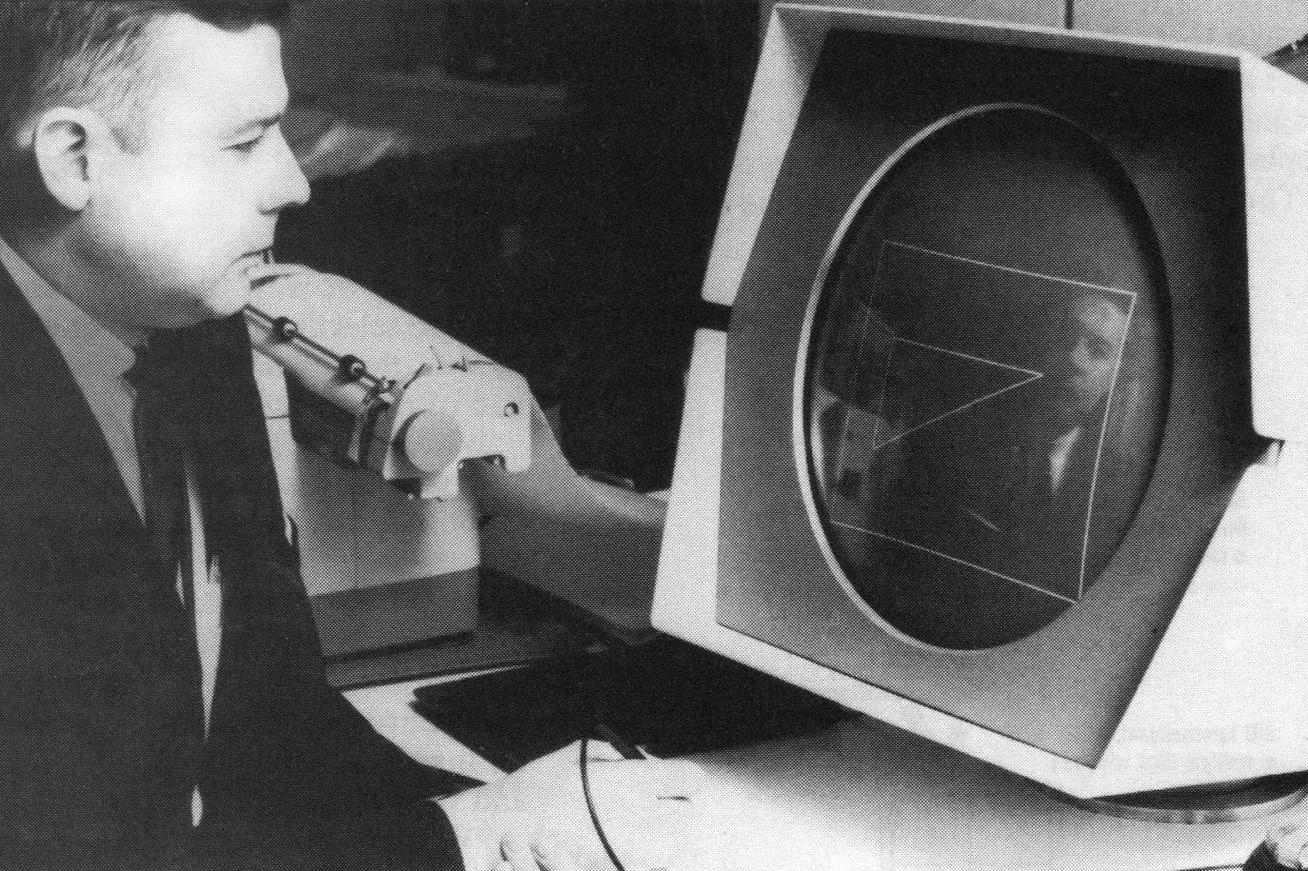

Można pomyśleć historię komputerów i oprogramowania jako historię redukcji poziomu trudności obsługi interfejsu między człowiekiem a mocą obliczeniową.

Kolejne warstwy abstrakcji software’u i frameworki design’u ułatwiają nam korzystanie z coraz większej mocy obliczeniowej oferowanej przez szybsze, mocniejsze komputery.

Od kart perforowanych i elektrycznych terminali przez linie komend i terminale systemowe, po graficzne interfejsy wspierające peryferia i w końcu ekrany dotykowe.

Każdy kolejny etap wymagał coraz mniejszych kompetencji, coraz mniej czasu, uwagi i wysiłku użytkownika, aby użyć komputera w pożądanym celu.

Ale interakcja z komputerem może być jeszcze naturalniejsza niż dotąd.

Myślę o czacie jako paradygmacie UI i szerzej - o komunikacji z komputerem w języku naturalnym.

Humane AI próbuje dokonać takiego przełomu.

TL;DR: Humane AI Pin to rodzaj wpinki lub broszki, poprzez którą można komunikować się głosowo z OpenAI. Sprzęt ma kamerę, sensory ruchu i głośnik. Ale też rzutnik do wyświetlania interfejsu na dłoni.

Najpierw jednak nieco kontekstu, żeby lepiej uchwycić zamiar Humane AI:

Myślę, że mamy obecnie swoisty wyścig o to, kto zdefiniuje sztuczną inteligencję jako nową formę oprogramowania.

Giganci ery internetowej - Microsoft, Google, Amazon, Meta - przyjęli różne teorie zwycięstwa w walce o to, kto i w jaki sposób użyje AI aby odmienić internet. Konkurencja nabiera na sile.

Walczą giganci osobiście i przez swoje proxy (OpenAI, Anthropic, AI21 Labs). Znów ściera się open source (korporacyjny, od Meta) z podejściem zamkniętym (OpenAI aka CloseAI hehe).

Mali korsarze, indie developerzy wypuszczający wrappery na API OpenAI i większe startupy również biorą udział w zabawie - ale to ci najwięksi nadają jej ton.

Inaczej niż kiedyś, AI wydaje się, póki co, nie tyle nową platformą, kolejnym kontynentem do eksploracji i dominacji, ale bardziej nowym typem uzbrojenia pozwalającym uczestnikom gry przesuwać fronty.

Internet to już nie to samo co kiedyś.

Pole gry o internet zostało już ustabilizowane: penetracja mobile i PC w krajach rozwiniętych jest wymaksowana, a granice biznesowej konkurencji - wytyczone.

Walka o udział w screen time to częściej wojna pozycyjna niż startupowy land grab sprzed dekady ze swoim imperatywem wzrostu za wszelką cenę.

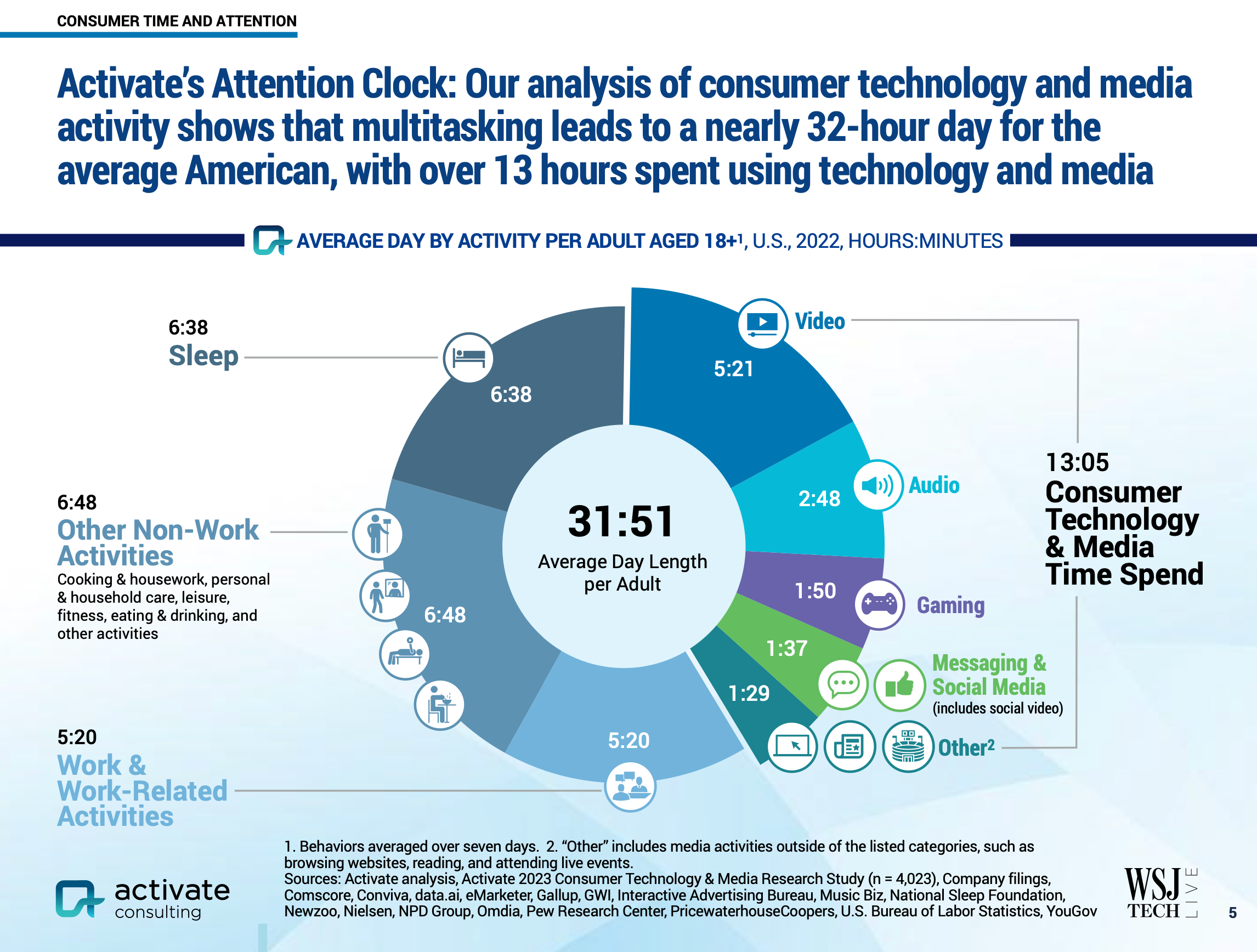

Dzięki mobile i powszechnemu dostępowi do internetu rywalizacja o użytkownika to właśnie rywalizacja o jego uwagę, jego screen time.

Po nieco ponad dekadzie od rewolucji smartfonowej poziom nasycenia uwagi użytkowników komputerów i smartfonów realnie wypełnia większość doby.

Mobile ate our attention chciałoby się powiedzieć - tylko że nie do końca tak jest.

„Większość doby” to przecież nie cała doba. Poza screen time musi być też jakiś off-screen time.

Czas bez ekranu to czas niezagospodarowany przez komputery, oprogramowanie i internet. To jest właśnie kolejny kontynent do odkrycia. I to tutaj Humane AI Pin lokuje swoje ambicje.

Oczywiście nie jest to pierwsza próba wejścia w off-screen time. Alexa, Cortana, Siri, HomePod, Nest i inni to pionierzy, którzy przetarli szlak.

Nie przesadzę chyba, jeśli powiem, że wszyscy zawiedli w sensie, że nie zrealizowali swojej obietnicy - pozostały po nich głównie głośniki i częściowo rozwinięta technologia automatyzacji domu.

Warunki możliwości screenless computing (albo IoT 2.0) ustanowiła dopiero technologia dużych modeli językowych.

Ponieważ interakcja z nimi jest możliwa za pośrednictwem języka naturalnego (innowacja ChataGPT) oraz za pośrednictwem mowy to możliwe jest, dosłownie, wykorzystywanie komputerów, także mobilnych (z kamerą, sensorami, etc.) bez konieczności używania ekranu.

Inaczej niż w przypadku IoT 1.0 mówimy tu o dwustronnej interakcji w języku naturalnym między AI w pudełku („Ghost in the shell”), zamiast o wykorzystywaniu urządzenia jako zaledwie sensora podłączonego do aplikacji internetowej, w której dane są przetwarzane.

To duża zmiana.

Głos jest naturalniejszym i gęstszym informacyjnie interfejsem niż czytanie i pisanie czy stukanie w ekran.

Ale to nie jest jedyna stawka rozgrywki rozpoczętej przez Humane AI.

Słabością Humane AI Pin jest to, że oprogramowanie Pina nie należy do firmy.

AI, które występuje w nazwie firmy dostarcza OpenAI. Trudna sprawa.

Ponieważ Humane AI realnie nie używa własnego modelu LLM to jest obecnie eksperymentem, którego hipoteza to: hardware to bardzo dobry klient dla AI.

Taki nowy bundle, AI + sprzęt, ma szansę zbudować zupełnie nową kategorię rynkową.

Sukces tego eksperymentu może otworzyć nowy rozdział w historii komputerów i oprogramowania - nie tylko jako historii interfejsów między ludźmi a mocą obliczeniową.

PS. Humane AI Pin oraz Raybany od Meta mają szansę otworzyć jeszcze kilka innych dyskusji.

Linie napięcia dostrzegam także na tych osiach:

- Screen computing vs. screenless computing.

- Hardware jako klient AI vs. aplikacje jako klienci AI.

- AI jako ekstensja clouda (OpenAI) vs. małe modele LLM działające jako edge computing AI

- Pełna integracja oprogramowania i hardware’u (jak Apple i kiedyś Microsoft z Nokią) vs. modularyzacja OEMów (jak Google z Androidem a wcześniej Wintel).

- Udostępnij na Twitterze

- Udostępnij na Facebooku

- Udostępnij na LinkedIn

- Udostępnij na Pinteresta

- Udostępnij przez Email

- Skopiuj link

Kuba Jeziorny • newsletter

Dołącz aby otrzymywać emailem powiadomienia o nowych wpisach.